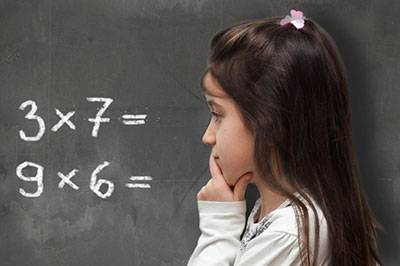

Evaluación formativa del alumnado con discalculia mediante la prueba analítica EVADAC (Parte II)

Diversas revisiones actuales resaltan la necesidad de que el profesorado utilice instrumentos de observación y registro válidos y fiables para la evaluación formativa y continua, destacando entre éstos a las listas de control o checklist (Hamodi, López & López, 2015). Con este objetivo se ha realizado un estudio de diseño instrumental y ex post facto, para desarrollar una prueba analítica como instrumento de observación de las dificultades de aprendizaje en el cálculo aritmético, alrededor de una checklist y mediante el tipo de registro más ampliamente utilizado en educación, el sistema de categorías.

3.2. Instrumento

Como resultado de estos estudios, se diseñó la prueba analítica para la Evaluación de las Dificultades de Aprendizaje del Cálculo, EVADAC (Coronado-Hijón, 2017):

Conformada por los siguientes materiales:

- Una prueba de desempeño académico en el cálculo aritmético diseñada desde la significatividad lógica, que recoge 40 algoritmos de las 4 operaciones aritméticas básicas siguiendo un orden de graduación de dificultad de las operaciones, similar al de otras pruebas de desempeño (Artiles & Jiménez, 2011), configurando de esta manera una prueba analítica para la identificación y dimensionalización de las dificultades de aprendizaje aritmético. Esta prueba se divide, a su vez, en dos subpruebas ajustables al proceso de enseñanza y aprendizaje y nivel curricular aritmético de los sujetos evaluados.

- Una checklist o lista de verificación o cotejo, constituida por cuatro categorías relativas a las dificultades con mayor prevalencia en el cálculo de las cuatro operaciones aritméticas básicas.

- Ejemplificaciones descriptivas de cada tipo de dificultades, cuya finalidad es el entrenamiento de los observadores en la identificación de DAC, que acompaña a modo de guía el proceso de evaluación, para facilitar la evaluación formativa.

- Hoja de Registro de doble entrada en relación a los tipos de dificultades y la secuenciación y complejidad curricular de éstas.

- Informe para la evaluación formativa compartida: de carácter descriptivo y dimensionador con el objetivo de orientar la atención a las necesidades específicas de apoyo educativo que presente el alumnado evaluado, dentro del enfoque de “evaluar para aprender” (Anijovich & González, 2011).

El informe final individual será descriptivo, formativo y criterial, con la aportación de los datos relativos a la frecuencia absoluta observada de cada tipo de error y a la frecuencia relativa mostrada, analizando el perfil de dificultades mostrado, referente al tipo concreto de error que presenta el alumnado evaluado y en el tipo y nivel curricular de la operación aritmética.

La retroalimentación que aporta esta prueba, a través de la identificación de los errores específicos de cada sujeto, permite dirigir la autorregulación del discente sobre sus necesidades de aprendizaje específicas.

4. Resultados.

El objetivo de la prueba experimental, fue la constatación positiva de los dos requisitos fundamentales que han de cumplir las pruebas e instrumentos de diagnóstico y evaluación educativa para confirmar la calidad de los datos que nos proporcionan: la validez y la fiabilidad. Los datos se analizaron utilizando el paquete estadístico SPSS.18.

Los valores de la validez de constructo, considerada como prueba mayor que engloba a las de criterio y de contenido (Bernal, 2018) fue medida mediante un análisis factorial exploratorio clásico, que fundamenta la consideración de una estructura factorial en que los índicadores que definen un factor muestren valores de .50 o más en este factor (Nunnally & Bernstein, 1994). En este estudio, todas las comunalidades se mostraron por encima de .50, salvo una que con un peso de .48 se sitúa muy cercana a este valor, por lo que podemos concluir que los indicadores de DAC están bien representados y de forma bastante equilibrada y homogénea. En un estudio de revisión desarrollado por Henson y Roberts (2006) sobre 60 estudios de análisis factoriales, observaron que, en todas estas investigaciones, la proporción media de varianza explicada por los factores era del 52.03 %, siendo en nuestro estudio del 65,19%.

Para estimar la consistencia interna o fiabilidad de las medidas se utilizó el estadístico Alfa de Cronbach, por ser el más ampliamente utilizado para este tipo de análisis. Esta medida valora el grado en que los ítems de una escala miden un mismo constructo y están correlacionados, de tal manera que si Alfa se sitúa en un valor cercano a 1 tendrá mayor consistencia interna. Los datos para el grupo de 4º de EP mostraron un índice de 0’904 y de 0’865 para el grupo de final de la etapa. Siguiendo el criterio de George y Mallery (2003), el Alfa de Cronbach; en el intervalo 0,8-0,9 se puede calificar como de un nivel de fiabilidad bueno.

Respecto a la necesaria comprobación de la concordancia entre observadores, el índice Kappa de Fleiss, mostró un grado de concordancia moderado, por encima de aceptable, según la categorización más aceptada, propuesta por Landis y Koch (1977).

- Índice Kappa 4º EP: 0’5363.

- Índice Kappa 6º EP: 0’4429.

5. Discusión y Conclusiones

Los estudios de evaluación formativa aplicada al alumnado con dificultades de aprendizaje del cálculo o discalculia dentro de un proceso de retroalimentación compartida, está centrada actualmente hacia la importancia de la identificación del error (Coronado-Hijón, 2018).

Desde una aproximación de orientación cognitiva, al estudio de los errores discalcúlicos, se postula que las dificultades en el aprendizaje del cálculo son susceptibles de desfragmentación en diversos componentes de un procesamiento interno de carácter cognitivo, para cuya identificación se requieren métodos indirectos de observación, como el análisis de los errores (Coronado-Hijón, 2014)

En el ámbito específico de las dificultades de aprendizaje del cálculo, la evaluación formativa surge como un complemento necesario al diagnóstico clínico psicométrico de éstas, ya que este último no aporta información específica sobre las dificultades y errores concretos del sujeto valorado. Datos que si aporta la evaluación formativa criterial, y compartida en cuanto a la devolución de información obtenida en la evaluación, al alumnado con esas dificultades, aspecto clave en una posterior intervención educativa a las necesidades específicas del apoyo educativo específico que requiere cada caso en particular. Para facilitar ésta, el diseño y posterior validación de pruebas analíticas de evaluación formativa y compartida basadas en una metodología observacional sistematizada abre paso a nuevos horizontes sobre la comprensión y atención educativa de esas dificultades de aprendizaje.

Diversas revisiones actuales resaltan la necesidad de que el profesorado utilice instrumentos de observación y registro válidos y fiables para la evaluación formativa y continua, destacando entre éstos a las listas de control o checklist (Hamodi, López & López, 2015). Con este objetivo se ha realizado un estudio de diseño instrumental y ex post facto, para desarrollar una prueba analítica como instrumento de observación de las dificultades de aprendizaje en el cálculo aritmético, alrededor de una checklist y mediante el tipo de registro más ampliamente utilizado en educación, el sistema de categorías.

El estudio de la validez de contenido del EVADAC, reflejó que los ítems son una muestra relevante y representativa de las dificultades de aprendizaje en el cálculo aritmético.

Los valores de la validez de constructo, medidos mediante un análisis factorial exploratorio clásico, refleja que los indicadores están bien representados y de forma bastante equilibrada y homogénea. También es relevante que el 65,194 % de la varianza total se explicaba por 8 componentes principales o indicadores de dificultades de aprendizaje en el cálculo de la suma y la resta, lo que indica el peso de éstos en estas dificultades, tal como se ha constatado en estudios posteriores (Coronado-Hijón, 2014).

La fiabilidad, definida como la constancia o estabilidad de los datos que proporciona un instrumento de observación o medida, se ha estimado mediante el estadístico Alfa de Cronbach, que es el más utilizado en la bibliografía, en este tipo de análisis. Los coeficientes de fiabilidad son interpretados como una correlación, considerándose que valores superiores a 0,75 indican alta fiabilidad (George & Mallery, 2003). El resultado obtenido para el total de sujetos de los dos grupos ha sido de 0,890. Este mismo buen nivel de fiabilidad mostrado en el total de las observaciones se observa cuando desglosamos los datos para el grupo de 4ºP con un índice de 0’904 y de 0’865 para 1ºESO.

Las mediciones que se obtienen mediante esta prueba, aportan datos de identificación y dimensionalización de los errores y necesidades específicas de apoyo educativo, facilitando así el reporte y retroalimentación educativa necesaria en una evaluación formativa de las dificultades de aprendizaje del cálculo aritmético dirigido a la autorregulación del proceso de aprendizaje de manera exitosa.

Podemos concluir que la prueba EVADAC (Coronado-Hijón, 2017), presenta buenas propiedades psicométricas de validez y fiabilidad, una procedimiento fácil de administrar y de informar, que permite discriminar el nivel de competencia e identificación y dimensionalización (Coronado-Hijón, 2018) de los errores específicos de DAC en los sujetos estudiados. Estas cualidades hacen de este instrumento de observación sistematizada un material idóneo para un tipo de diagnóstico pedagógico ligado a la evaluación formativa y por tanto, al alumnado en riesgo y a la prevención.

Esta contribución responde, de esta manera, a una necesidad expresada desde hace tiempo en el ámbito de la evaluación educativa de la discalculia: la escasez de instrumentos para su evaluación formativa con valores de validez y fiabilidad contrastados. En esta dirección, esperamos que este trabajo acreciente esta incipiente línea de investigación sobre materiales y pruebas de evaluación formativa en este ámbito de las dificultades de aprendizaje.

Referencias

Anderson, L. W. (2014). Benjamin S. Bloom: His life, his works, and his legacy. Educational Psychology: A Century of Contributions: A Project of Division 15 (educational Psychology) of the American Psychological Society, 367.

Anguera, M.T. & Izquierdo, C. (2006). Methodological approaches in human communication. From complexity of situation to data analysis. In G. Riva, M.T. Anguera, B.K. Wiederhold & F. Mantovani (Coord.), From Communication to Presence. Cognition, Emotions and Culture towards the Ultimate Communicative Experience (pp. 203-222). Amsterdam: IOS Press.

Anguera, M.T. (2010). Posibilidades y relevancia de la observación sistemática por el profesional de la psicología. Papeles del Psicólogo, 31 (1), 122-130.

Anijovich, R., & González, C. (2011). Evaluar para aprender: conceptos e instrumentos. Buenos Aires: Aique.

Appavoo, P., Armoogum, V., & Soyjaudah, S. (2018). Investigating Mathematics Learning Trajectories: A Comparative Analysis of Grades at Two Major Turning Points. Eurasia Journal of Mathematics, Science and Technology Education, 14(4), 1263-1272.

Artiles, C. & Jiménez, J. E. (2011). Normativización de instrumentos para la detección e identificación de las necesidades educativas del alumnado con trastornos por déficit de atención con o sin hiperactividad o alumnado con dificultades específicas de aprendizaje. Las Palmas de Gran Canaria: Consejería de Educación, Universidades, Cultura y Deportes.

Bernal Pablo, P. (2018). La Investigación en Ciencias Sociales: Tecnicas de recolección de la información. Universidad Piloto de Colombia.

Black, P., & William, D. (2009). Developing the theory of formative assessment. Educational Assessment, Evaluation and Accountability (formerly: Journal of Personnel Evaluation in Education), 21(1), 5.

Booth, M. (2012). Learning Analytics: the new black. Educause Review Online. Retrieved from http://www. educause. edu/ero/article/learning-analytics-new-black.

Brookhart, S. M. (2009). Editorial, Educational Measurement: Issues and Practice, vol. 28 (1), 1-2.

Butler, D. L. (1998). The strategic content learning approach to promoting self regulated learning: A report of three studies. Journal of Educational Psychology, 90(4), 682-697. https://doi.org/10.1037/0022-0663.90.4.682

Capella-Peris, C., Gil-Gómez, J., Chiva-Bartoll, O. & Martí-Puig, M. (2015). Diseño y validación de una rúbrica para valorar la competencia docente en la didáctica de juegos motores y expresión corporal en Educación Infantil. Ágora para la Educación Física y el Deporte, 17(2), 148-167

Castro, B., & Casado, O. M. (2017a). La evaluación formativa en el aprendizaje de la lectoescritura en Educación Infantil. En V. López-Pastor & A. Pérez Pueyo (Coord.) (2017), Evaluación formativa y compartida en Educación: experiencias de éxito en todas las etapas educativas. León: Servicio de publicaciones de la Universidad de León.

Castro, B., & Casado, O. M. (2017b). La autorregulación en Educación Infantil es posible. Infancia, Educación y Aprendizaje, 3(2), 324-328. http://dx.doi.org/10.22370/ieya.2017.3.2.759

Clark, I. (2012). Formative assessment: Assessment is for self-regulated learning. Educational Psychology Review, 24(2), 205-249.

Coronado-Hijón, A. (2014). Estudio de prevalencia de dificultades de aprendizaje en el cálculo aritmético. Bordón. Revista de Pedagogía, 66(3), 39-59. DOI: 10.13042 /Bordon.2014.66303

Coronado-Hijón, A. (2015). Construcción de una lista de cotejo (checklist) de dificultades de aprendizaje del cálculo aritmético. Revista española de pedagogía, 91-104.

Coronado-Hijón, A. (2017). EVADAC. Madrid: GiuntiEos.

Coronado-Hijón, A. (2018). Dificultades de aprendizaje aritmético: Identificación y dimensionalización educativa. En López-Meneses, E., Cobos-Sanchiz, D., Martín-Padilla, A.H., Molina-García, L. & Jaén-Martínez, A. (Eds.) Experiencias pedagógicas e Innovación educativa: aportaciones desde la praxis docente e investigadora. Barcelona: Editorial Octaedro.

Fauzan, A., Armiati, A., & Ceria, C. (2018, April). A Learning Trajectory for Teaching Social Arithmetic using RME Approach. In IOP Conference Series: Materials Science and Engineering (Vol. 335, No. 1, p. 012121). IOP Publishing.

George, D., & Mallery, P. (2003). SPSS for Windows step by step: A simple guide and reference. 11.0 update (4th ed.). Boston, MA: Allyn & Bacon.

González, M. J., Gómez, P., & Restrepo, Á. M. (2015). Usos del error en la enseñanza de las matemáticas. Revista de Educación, 370, 71-95.

Hamodi, C., López Pastor, V. M., & López Pastor, A. T. (2015). Medios, técnicas e instrumentos de evaluación formativa y compartida del aprendizaje en educación superior. Perfiles educativos, 37(147), 146-161.

Hawes, Z., Nosworthy, N., Archibald, L., & Ansari, D. (2019). Kindergarten children's symbolic number comparison skills predict 1st grade mathematics achievement: Evidence from a two-minute paper-and-pencil test. Learning and Instruction, 59, 21-33.

Herholdt, R., & Sapire, I. (2014). An error analysis in the early grades mathematics-A learning opportunity? South African Journal of Childhood Education, 4(1), 43-60.

Henson, R. K., & Roberts, J. K. (2006). Use of exploratory factor analysis in published research: Common errors and some comment on improved practice. Educational and Psychological Measurement, 66(3), 393-416.

Horowitz, S. (2011). Lista de Verificación de las Discapacidades de Aprendizaje. New York: The National Center for Learning Disabilities, 73(260).

Hou, F., Qi, L., Liu, L., Luo, X., Gu, H., Xie, X.,... & Song, R. (2018). Validity and Reliability of the Dyslexia Checklist for Chinese Children. Frontiers in psychology, 9, 1915.

Kirk, S. A., & Bateman, B. (1962). Diagnosis and remediation of learning disabilities. Exceptional Children, 29, 73-78.

Kline, R. (2011). Principles and practice of structural equation modeling. 3 ed. Nueva York: The Guilford Press.

Landis, J. R. & Koch, G. G. (1977). The measurement of observer agreement for categorical data. Biometrics, 33, 159-174.

López, E. (2006). El Mastery Learning a la luz de la investigación educativa. Revista de Educación, 340, 625-665.

McMillan, J. H. (2010). The practical implications of educational aims and contexts for formative assessment. Handbook of formative assessment. New York: Routledge, 41-58.

Morán-Barrios, J. (2016). La evaluación del desempeño o de las competencias en la práctica clínica. 1. a Parte: principios y métodos, ventajas y desventajas. Educación Médica, 17(4), 130-139.

Neuendorf, K. A. (2011). Content analysis—A methodological primer for gender research. Sex Roles, 64(3-4), 276-289.

Nunnally, J. C., & Bernstein, I. H. (1994). Psychometric Theory (McGraw-Hill Series in Psychology) (Vol. 3). New York: McGraw-Hill.

Obando, G. & Muñera, J. J. (2003).Las situaciones problemas como estrategia para la conceptualización matemática. Revista Educación y Pedagogía. Vol. XV, no. 35, 85 -199.

Ortiz, M.R., (2004). Manual de Dificultades de Aprendizaje. Madrid: Pirámide.

Bernal Pablo, P. (2018). La Investigación en Ciencias Sociales: Técnicas de recolección de la información. Bogotá: Universidad Piloto de Colombia.

Pérez Sánchez, A.M. (2009). Dificultades de aprendizaje de las matemáticas. En Castejón, Navas (Eds.). Unas bases psicológicas de la educación especial. Alicante: Club Universitario.

Popham, W. J. (2008). Transformative Assessment. Alexandria: Association for Supervision and Curriculum Development.

Ramírez, M., & De Castro, C. (2014). Trayectorias de aprendizaje de la multiplicación y la división de cuatro a siete años. Épsilon. Revista de Educación Matemática, 31(3), 41-56.

Sadler, D. R. (1989). Formative assessment and the design of instructional systems. Instructional Science, 18(2), 119-144.

Scriven, M. (1967). The Methodology of Evaluation. In. Tyler, RW, Gagne, RM, Scriven, M. (ed.): Perspectives of Curriculum Evaluation, Rand McNally, Chicago.

Socas, M. M. (2007). Dificultades y errores en el aprendizaje de las Matemáticas. Análisis desde el enfoque Lógico Semiótico. Investigación en Educación Matemática XI, 19-52.

Socas, M. M. (2011). Aprendizaje y enseñanza de las Matemáticas en Educación Primaria. Buenas prácticas. Educatio Siglo XXI, 29 (2), 199-224

Stenhouse, L. (1984). Investigación y desarrollo del currículum. Madrid: Morata

Zapatera, A. (2018). Cómo alumnos de educación primaria resuelven problemas de generalización de patrones. Una trayectoria de aprendizaje. Revista Latinoamericana de Investigación en Matemática Educativa, 21(1).

Día del libro

10% DESCUENTO

Máximo permitido en libros*

G R A T I S

-

Un libro que interesará tanto a los amantes de la lectura como a los que sienten curiosidad sobre el funcionamiento del cerebro hu...10% de descuentoPrecio: 5.99€

5.39€

5.39€ -

Divertido juego para toda la familia en el que deberemos reunir a un montón de animales diferentes y, ¡tendremos que alimentarlos...10.93 €

-

Esta revista trata sobre temas selectos en psicológica y ética profesional del orientador psicológico....10% de descuentoPrecio: 17.11€

15.40€

15.40€ -

La aplicación de los principios y técnicas de la Programación Neurolingüística (PNL) a la actividad docente pueden suponer un avan...10% de descuentoPrecio: 20.50€

18.45€

18.45€

ARTÍCULOS RELACIONADOS

- Manual de actividad psicopedagógica para el aprendizaje de los niños incluidos con trastorno del desarrollo intelectual de Consolación del Sur

- Dislexia. Detección y estado actual

- Beneficios de la musicoterapia

- Evaluación formativa del alumnado con discalculia mediante la prueba analítica EVADAC (Parte I)

- Evaluación formativa del alumnado con discalculia mediante la prueba analítica EVADAC (Parte I)

- La importancia de la comunicación de vías aferentes y eferentes en el aprendizaje (Parte I)

- La importancia de la comunicación de vías aferentes y eferentes en el aprendizaje (Parte II)

- Una forma diferente de pensar. Conociendo la dislexia y sus causas (Parte I)

- Una forma diferente de pensar. Conociendo la dislexia y sus causas (Parte II)